A Microsoft admite que agentes de IA podem ter alucinações e cair em golpes, mas mesmo assim chegarão ao Windows 11.

Nas últimas semanas, a Microsoft tem associado agentes de IA ao futuro do Windows . Mas a própria documentação da empresa admite abertamente que esses agentes podem ter alucinações, agir de forma imprevisível e até mesmo cair em ataques que não existiam há um ano. Mesmo assim, a quarta maior empresa do mundo continua insistindo em recursos de agentes no Windows 11.

Se a Microsoft acredita que esses agentes são suficientemente arriscados para necessitarem de contas separadas, sessões isoladas e registros de auditoria à prova de adulteração, por que o Windows 11 está se tornando o campo de testes para eles? E por que agora, em um momento em que os usuários já estão exaustos com a crescente inteligência artificial do sistema operacional?

A grande aposta da Microsoft na computação agente já está consolidada.

Em meados de outubro de 2025, a Microsoft anunciou que transformaria "todo PC com Windows 11 em um PC com IA". A empresa revelou uma série de integrações de IA que permitiriam "conversar" com o computador, mostrar a ele o que está na tela e, em seguida, fazer com que ele agisse em seu nome.

Essencialmente, a Microsoft quer que você substitua as teclas digitadas e os cliques do mouse por linguagem natural, e pudemos ver uma prévia desse plano com o Copilot Voice , o Copilot Vision e a parte de interação com agentes, o Copilot Actions.

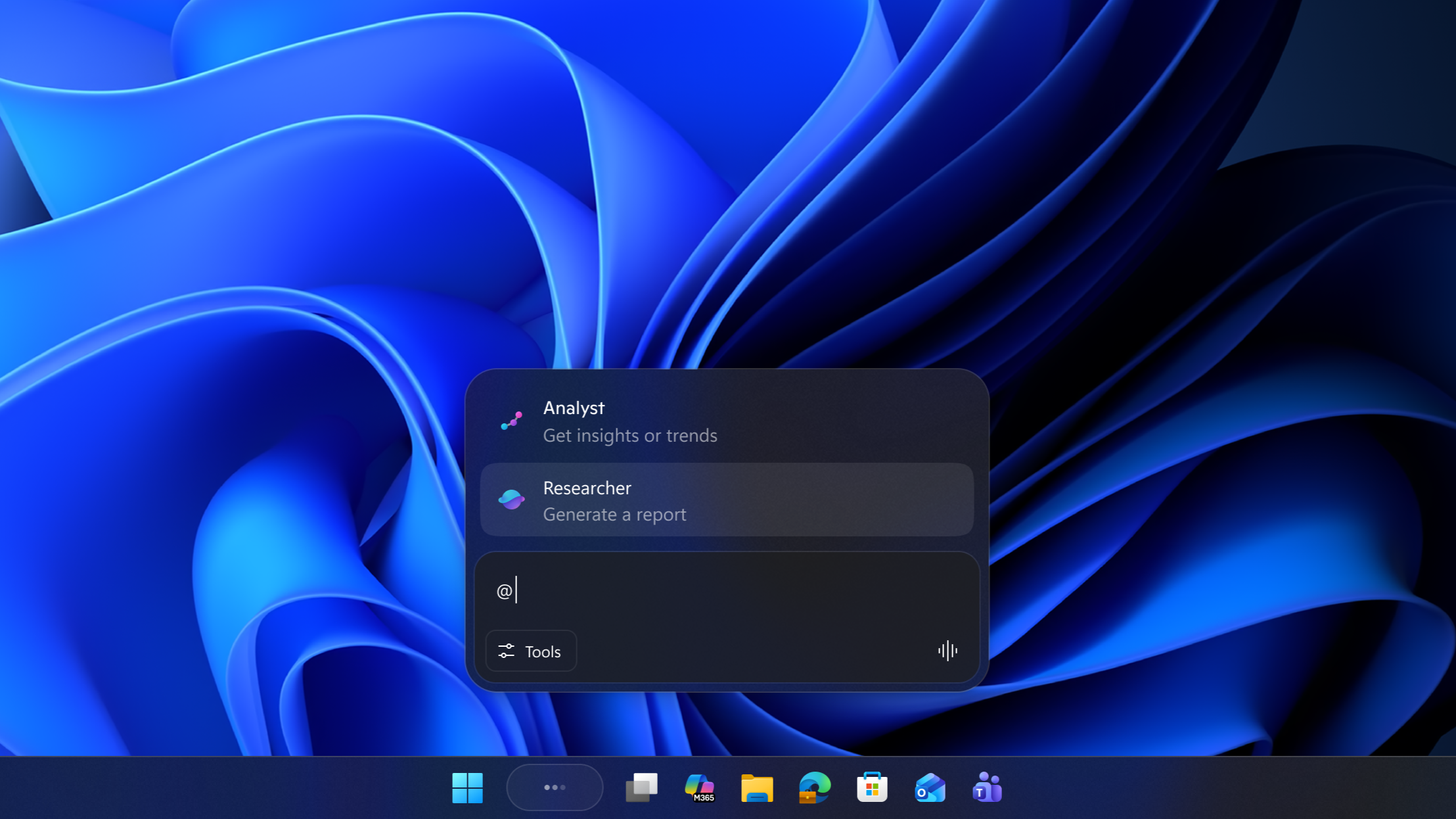

As últimas mudanças transformam a barra de tarefas do Windows 11 no centro nevrálgico dessa IA. A caixa de pesquisa do Windows 11 está sendo substituída (opcional, por enquanto) por uma nova interface " Pergunte ao Copiloto " que permite invocar agentes de IA ou o Copiloto com um único clique ou digitação. A partir daí, os agentes podem executar tarefas em segundo plano e você pode monitorar o progresso delas diretamente da barra de tarefas, como se fossem aplicativos comuns.

Mesmo que hoje a funcionalidade de agentes seja limitada e opcional, a arquitetura e o roteiro deixam claro que a computação baseada em agentes é o próximo paradigma central para o Windows.

A Microsoft admite abertamente que os agentes de IA podem se comportar mal, mas ainda assim quer tê-los dentro dos seus arquivos e aplicativos.

Por outro lado, a Microsoft não finge que isso é seguro ou infalível. A documentação oficial da empresa alerta que esses agentes de IA “enfrentam limitações funcionais em termos de comportamento e, ocasionalmente, podem ter alucinações e produzir resultados inesperados”.

Os agentes são vulneráveis a Injeção de Prompt Cruzado (XPIA), prompts maliciosos e malware.

Um dos maiores riscos mencionados pela Microsoft é a Injeção de Prompt Cruzado (XPIA). Ela descreve uma situação em que um agente de IA é enganado por conteúdo malicioso incorporado em elementos da interface do usuário, documentos ou aplicativos. Esse conteúdo pode potencialmente substituir as instruções originais do agente e forçá-lo a executar ações prejudiciais, como copiar arquivos confidenciais ou vazar dados.

Pesquisadores de segurança já identificaram agentes baseados em interface gráfica como vulneráveis a esse tipo de ataque indireto, devido aos altos privilégios concedidos a esses agentes de IA.

Embora apreciemos a transparência da Microsoft sobre o assunto, surge uma certa desconfiança, considerando toda a rejeição que o Copilot vem recebendo ultimamente. E se você acha que o Recall foi um pesadelo para a privacidade , os agentes de IA são um caso completamente diferente.

A Microsoft insiste que os agentes sejam executados em contas separadas, com permissões limitadas, acesso controlado a pastas e registros à prova de adulteração. Mas ainda concede a esses agentes acesso de leitura e gravação a alguns dos nossos locais mais pessoais no PC, especificamente Documentos, Downloads, Área de Trabalho, Vídeos, Imagens e Música, que a Microsoft chama de pastas conhecidas .

“…conteúdo malicioso incorporado em elementos da interface do usuário ou documentos pode sobrepor-se às instruções do agente, levando a ações indesejadas, como exfiltração de dados ou instalação de malware”, alertou a Microsoft em um documento de suporte publicado no início deste mês. “Recomendamos que você leia estas informações e compreenda as implicações de segurança de habilitar um agente em seu computador.”

Então, considerando os riscos, se a Microsoft quer que os agentes interajam com aplicativos e arquivos como uma pessoa real, como exatamente ela impede que todo o sistema entre em colapso sob o próprio peso?

Tudo depende de um novo recurso chamado Espaço de Trabalho do Agente.

O Agent Workspace é a espinha dorsal da visão da Microsoft para um sistema operacional com agentes. Tudo o que a empresa prometeu, incluindo a IA que usa aplicativos para você, edita arquivos, move documentos e conclui tarefas complexas sem incomodá-lo, só funciona porque o Windows 11 agora pode criar sessões dedicadas para esses agentes operarem.

É diferente de uma máquina virtual ou do Sandbox do Windows . O Agent Workspace é um ambiente Windows paralelo, completo com sua própria conta, sua própria área de trabalho, sua própria árvore de processos e seu próprio limite de permissões.

A criação de um espaço de trabalho separado para agentes de IA é a primeira tentativa da Microsoft de lhes dar um "local de existência" dentro do Windows, sem permitir que fiquem diretamente integrados à sessão do usuário.

Cada agente recebe uma conta padrão separada no seu PC, e o Windows trata essa conta como um usuário controlado e limitado que só pode fazer o que você autoriza explicitamente. Essas restrições são a resposta da Microsoft aos mesmos problemas sobre os quais ela alertou.

Como os agentes de IA funcionam no Windows 11

Nesse espaço de trabalho, o Agente interage com os aplicativos da mesma forma que nós. Ele pode clicar em botões da interface do usuário, digitar em campos de texto, navegar entre janelas, arrastar arquivos e executar tarefas que envolvem várias etapas. A IA cuida do raciocínio por trás dessas etapas.

O Copilot Actions já utiliza esse modelo. Em vez de solicitar que um modelo na nuvem gere texto, o agente executa as etapas diretamente no software instalado no seu computador. É por isso que a Microsoft precisa fornecer sessões separadas do Windows para ele.

Se um agente interpretar incorretamente uma solicitação ou se o XPIA for acionado dentro de um documento, o dano ficará, tecnicamente, contido dentro de um limite onde o Windows pode supervisionar e registrar cada ação.

O Espaço de Trabalho do Agente é responsável por decidir o que mostrar aos agentes. Como mencionei, os agentes só têm acesso às seis "pastas conhecidas". Todo o resto no perfil do usuário é restrito, a menos que você conceda acesso.

Isso também deve impedir que os agentes acessem diretórios do sistema, repositórios de credenciais ou pastas de dados de aplicativos, onde leituras ou gravações não intencionais causariam problemas para os desenvolvedores de aplicativos. A Microsoft também usa Listas de Controle de Acesso (ACLs) para impedir que a conta do agente ultrapasse as permissões do usuário que a habilitou.

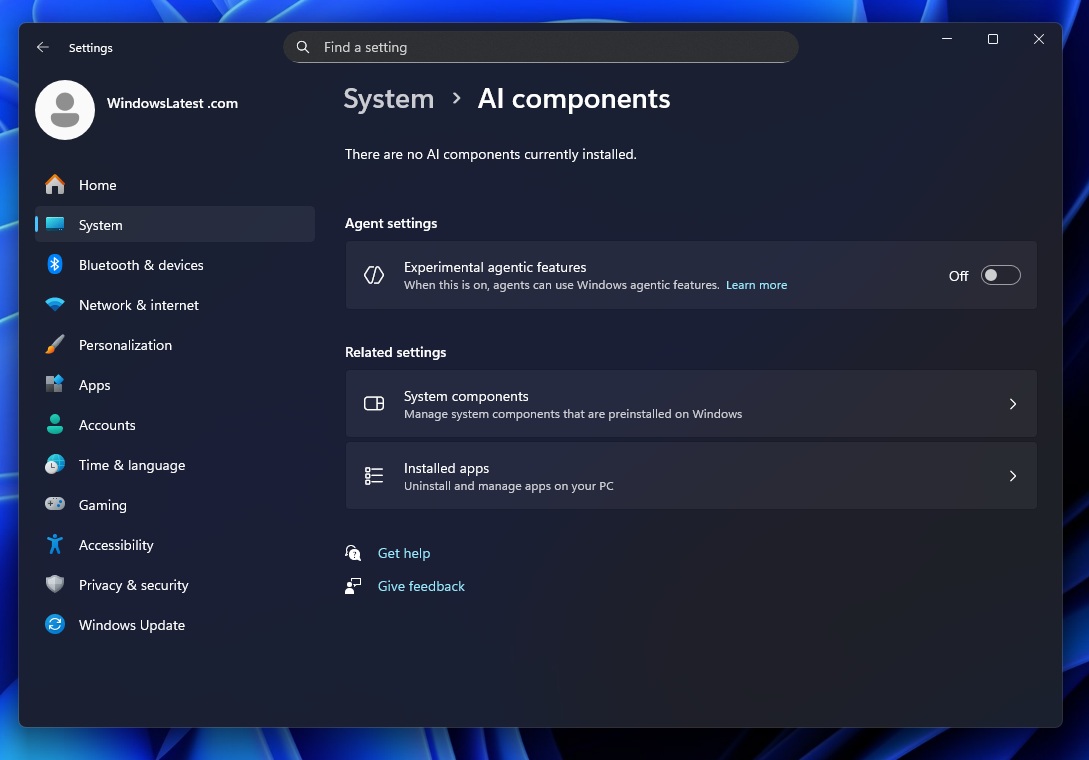

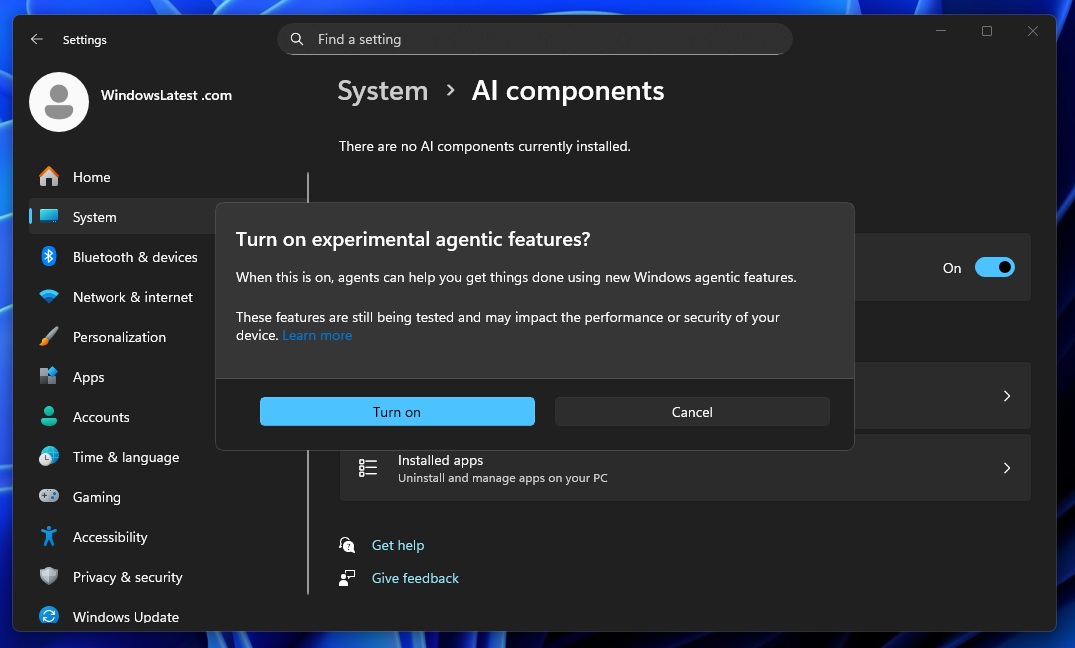

Para ativar qualquer uma dessas funcionalidades, você precisa habilitar os Recursos Agéticos Experimentais , que estão desativados por padrão.

A Microsoft afirma: “Este recurso não possui capacidades de IA por si só; trata-se de um recurso de segurança para agentes como o Copilot Actions. Habilitar essa opção permite a criação de uma conta de agente e um espaço de trabalho separados no dispositivo, proporcionando um ambiente isolado para manter a atividade do agente separada da do usuário.”

O protocolo MCP controla quais agentes podem interagir.

A Microsoft está posicionando o Model Context Protocol (MCP) como a ponte padronizada entre agentes e aplicativos. É assim que o agente se comunica com as ferramentas do sistema.

O MCP permite que o agente descubra ferramentas, chame funções, leia metadados de arquivos e interaja com serviços por meio de uma camada JSON-RPC previsível. Isso impede qualquer acesso direto e fornece ao Windows um ponto central de aplicação onde a autenticação, a permissão para usar ferramentas, as declarações de capacidade e o registro de logs são realizados. Sem o MCP, um agente estaria às cegas. O espaço de trabalho o mantém dentro de limites seguros.

Por que a Microsoft acredita que o risco com agentes de IA vale a pena?

Do ponto de vista da Microsoft, recuar em relação à IA não é mais uma opção. A empresa quer que as pessoas usem a IA naturalmente no Windows, a ponto de o sistema operacional se tornar uma "tela para IA".

A Apple está trabalhando arduamente no Apple Intelligence, especialmente devido ao plano de usar uma versão personalizada do Gemini , o que nos leva ao fato de o Google já estar planejando entrar no mercado de PCs com o Aluminium OS .

O MacBook de baixo custo da Apple , com uma versão completa do Apple Intelligence, será mais atraente para muitos, simplesmente devido ao prestígio da empresa. Portanto, se o Windows não estiver preparado, corre o risco real de a plataforma começar a parecer monótona, além de ser criticada pelos problemas já existentes no Windows 11, como a lentidão do Explorador de Arquivos .

Grandes corporações incentivando usuários a experimentarem novidades que, eventualmente, lhes rendem milhões em retorno sobre o investimento não é algo novo, mas será que você deveria confiar na Microsoft?

O Windows 11 já não tem uma boa reputação. As pessoas já reclamam de como ele parece pesado e lento.

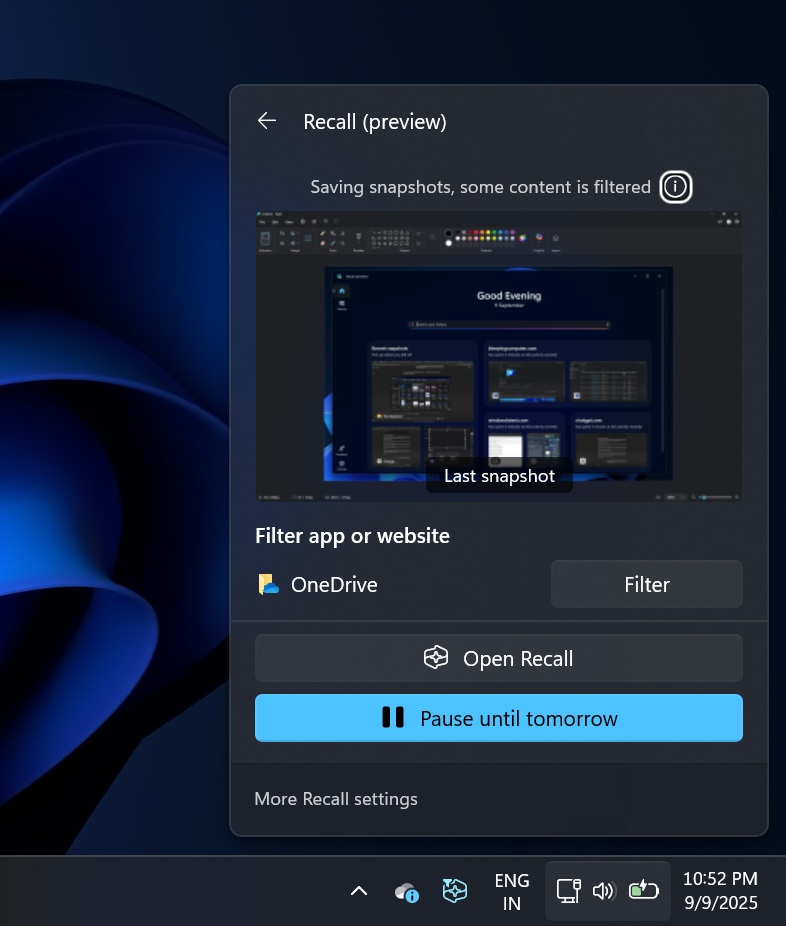

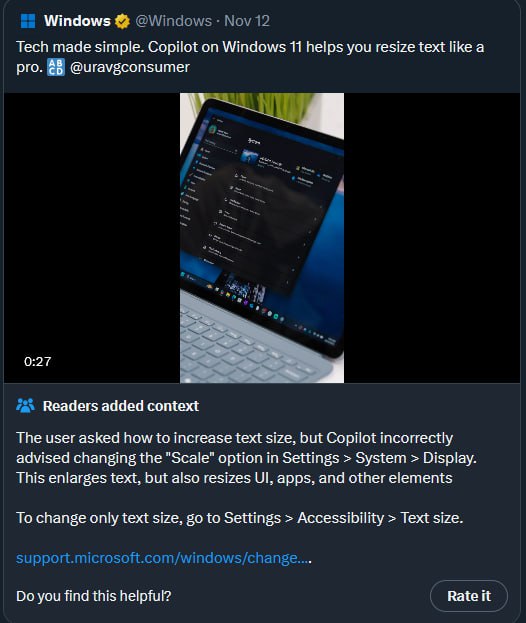

O recurso Recall da Microsoft tornou-se o exemplo clássico de como não lançar um produto de IA em um sistema operacional para desktops. Pesquisadores de segurança, defensores da privacidade e usuários comuns alertaram sobre a ideia de capturas de tela constantes da sua atividade serem armazenadas no disco.

A reação negativa foi tão forte que a Microsoft adiou o recurso , reformulou-o para que fosse opcional e ainda não consegue se livrar completamente do rótulo de "pesadelo para a privacidade". Mesmo agora, aplicativos focados em privacidade como Signal, Brave e AdGuard já vêm com medidas que bloqueiam o Recall por padrão .

Todo esse contexto deixa as pessoas apreensivas com a possibilidade do Windows se tornar um sistema operacional com agentes. Se o recurso Recall teve dificuldades para respeitar limites, o que acontecerá quando agentes também puderem clicar, digitar e mover arquivos para você?

A Microsoft está construindo um futuro arriscado e espera que os usuários a acompanhem.

A Microsoft optou por reconstruir o Windows 11 em torno de agentes de IA que podem realizar tarefas em seu nome. A empresa tem a coragem de admitir os riscos, mas também a confiança necessária para seguir em frente.

Sinceramente, no papel, a arquitetura parece inteligente. Contas separadas para agentes, espaços de trabalho isolados, acesso limitado a pastas, registro rigoroso de logs e uma camada de protocolo que permite ao Windows ficar entre os agentes e as ferramentas. Na prática, o sucesso ou fracasso dependerá da execução. Uma única vulnerabilidade grave poderia destruir grande parte da confiança que a Microsoft está tentando reconstruir após o Recall. Pelo menos, os recursos experimentais de agentes são opcionais por enquanto.

A verdade incômoda é que um sistema operacional com agentes é provavelmente inevitável, e não estou falando apenas do Windows. Todos os principais fornecedores de plataformas estão caminhando para um futuro onde a IA faça mais do que conversar com você.

O que não é inevitável é a confiança. A Microsoft terá que conquistá-la, especialmente dos usuários que já sentem que o Windows 11 está trabalhando contra eles. Se a empresa quer que as pessoas aceitem agentes de IA que residem em suas pastas pessoais, precisará começar tornando tudo completamente opcional e, em seguida, apresentar casos de uso válidos.

Comentários