TechSpot significa análise técnica e aconselhamento em que você pode confiar . Leia nossa declaração de ética .

Opinião do editor: Como quase todo mundo na área de tecnologia hoje, passamos o ano passado tentando entender a “IA”. O que é, como funciona e o que significa para a indústria. Não temos certeza se temos boas respostas, mas algumas coisas ficaram claras. Talvez surja a AGI (inteligência artificial geral), ou veremos algum outro grande avanço da IA, mas focar demasiado nesses riscos pode ser ignorar as melhorias muito reais – mas também muito mundanas – que as redes de transformadores já estão a proporcionar.

Parte da dificuldade em escrever este artigo é que estamos presos em uma espécie de dilema. Por um lado, não queremos descartar os avanços da IA. Esses novos sistemas são conquistas técnicas importantes, não são brinquedos adequados apenas para gerar fotos de gatinhos fofos vestidos no estilo dos mestres holandeses contemplando um prato de frutas como na imagem abaixo (gerada pelo Microsoft Copilot). Eles não deveriam ser facilmente descartados.

Nota do Editor:

O autor convidado Jonathan Goldberg é o fundador da D2D Advisory, uma empresa de consultoria multifuncional. Jonathan desenvolveu estratégias de crescimento e alianças para empresas dos setores móvel, de redes, de jogos e de software.

Por outro lado, a esmagadora maioria dos comentários públicos sobre a IA são absurdos. Ninguém que realmente esteja trabalhando na área hoje com quem conversamos pensa que estamos à beira da Inteligência Artificial Geral (AGI). Talvez estejamos a apenas um avanço de distância, mas não conseguimos encontrar ninguém que realmente acredite que isso seja provável. Apesar disso, a mídia em geral está repleta de todos os tipos de histórias que combinam IA generativa e AGI, com todo tipo de opiniões selvagens e infundadas sobre o que isso significa.

Deixando de lado todo o ruído, e há muito ruído , o que vimos no ano passado foi o surgimento das redes neurais baseadas em Transformers. Há anos que usamos sistemas probabilísticos em computação, e os transformadores são um método melhor, ou mais econômico, para realizar essa computação.

Isso é importante porque abre o espaço para problemas que podemos resolver com nossos computadores. Até agora, isso caiu em grande parte no domínio do processamento de linguagem natural e da manipulação de imagens. Eles são importantes, às vezes até úteis, mas se aplicam ao que ainda é uma parte bastante pequena da experiência do usuário e dos aplicativos. Computadores que possam processar com eficiência a linguagem humana serão muito úteis, mas não significam algum tipo de avanço computacional universal.

Isso não significa que a “IA” forneça apenas uma pequena quantidade de valor, mas significa que grande parte desse valor virá de maneiras bastante mundanas. Achamos que esse valor deve ser dividido em dois grupos – experiências generativas de IA e melhorias de baixo nível em software.

Considere o último – melhorias no software. Isto parece chato – é – mas isso não significa que não seja importante. Todas as grandes empresas de software e Internet hoje estão trazendo transformadores para suas pilhas. Na maioria das vezes, isso passará totalmente despercebido pelos usuários.

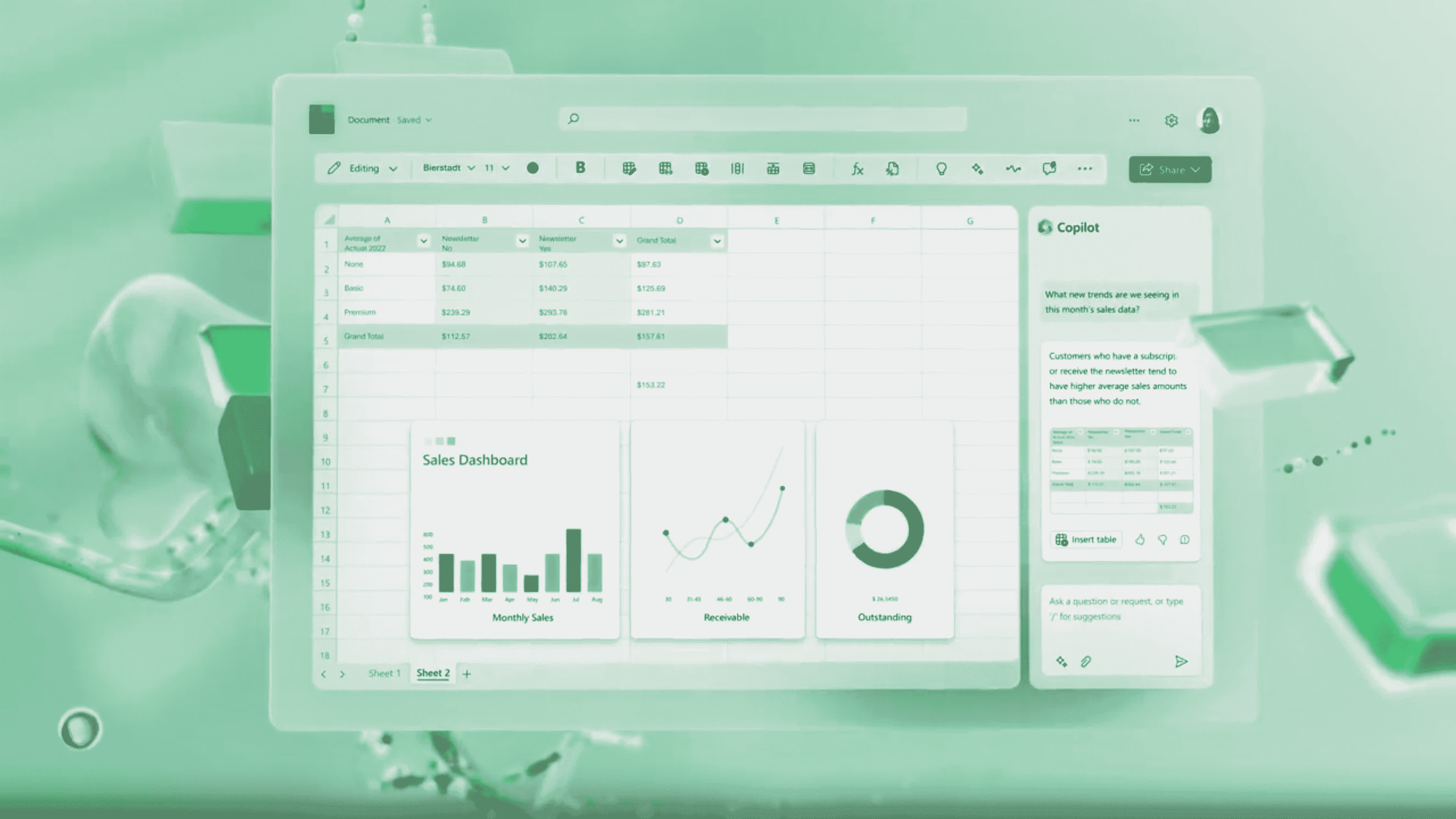

Imaginamos que a Microsoft possa ter alguns recursos muito interessantes para adicionar ao MS Word, PowerPoint e Visual Basic. Claro, vá em frente e nos impressione com AI Excel. Mas isso é muita esperança para uma empresa que não é muito conhecida por oferecer excelentes interfaces de usuário.

As empresas de segurança podem tornar seus produtos um pouco melhores na detecção de ameaças. Os sistemas de CRM podem ficar um pouco melhores na correspondência das solicitações dos usuários com resultados úteis. As empresas de chips melhorarão em certa medida a previsão de ramificação do processador. Tudo isso são pequenos ganhos, aumentos de 10% ou 20% no desempenho ou reduções de custos. E tudo bem, ainda é um valor tremendo quando combinado com todos os softwares disponíveis. No momento, acreditamos que a maior parte dos ganhos da “IA” ocorrerá nessas formas comuns, mas úteis.

A IA generativa pode revelar-se mais significativa. Talvez. Parte do problema que temos hoje neste campo é que grande parte da indústria tecnológica está à espera para ver o que todos os outros farão nesta frente.

Em todos os seus recentes comentários públicos, todas as grandes empresas de processadores apontaram a próxima atualização de IA da Microsoft como um grande catalisador para a adoção de semifinais de IA. Imaginamos que a Microsoft possa ter alguns recursos muito interessantes para adicionar ao MS Word, PowerPoint e Visual Basic. Claro, vá em frente e nos impressione com AI Excel. Mas é muita esperança manter uma única empresa, especialmente uma empresa como a Microsoft, que não é muito conhecida por oferecer ótimas interfaces de usuário.

Por sua vez, o Google parece ser um cervo nos faróis quando se trata de transformadores, o que é irônico, visto que foram eles que os inventaram. No final das contas, todo mundo está realmente esperando que a Apple nos mostre como fazer isso da maneira certa. Até agora, eles têm estado visivelmente calados em relação à IA generativa. Talvez eles estejam tão confusos quanto todos os outros, ou talvez simplesmente ainda não vejam a utilidade.

A Apple tem processadores neurais em seus telefones há anos. Eles foram muito rápidos em adicionar suporte a transformador às CPUs da Série M. Não parece correto dizer que eles estão ficando para trás em IA, quando talvez estejam apenas à espreita.

Voltando ao assunto dos semicondutores, pode ser tentador criar grandes expectativas e elaborar cenários de todas as formas como a IA impulsionará novos negócios. Daí a crescente quantidade de comentários sobre PCs com IA e o mercado de semicondutores de inferência. Não estamos convencidos, não está claro se alguma dessas empresas será realmente capaz de construir mercados massivos nestas áreas.

Em vez disso, tendemos a ver o advento de sistemas de IA baseados em transformadores em termos muito mais simples. A ascensão dos transformadores parece significar em grande parte uma transferência de influência e captura de valor para a Nvidia em detrimento da Intel no data center. A AMD pode conquistar sua parte nessa transferência, e talvez a Intel possa encenar o retorno de todos os retornos, mas no futuro próximo não há necessidade de complicar as coisas.

Dito isto, talvez estejamos entendendo tudo errado. Talvez haja grandes ganhos pairando por aí, algum grande avanço de um laboratório de pesquisa ou de uma startup de pré-produto deca-unicórnio. Não eliminaremos essa possibilidade. O que queremos dizer aqui é que já estamos vendo ganhos significativos com transformadores e outros sistemas de IA. Todas essas melhorias “invisíveis” no software já são significativas, e não devemos nos angustiar esperando pelo surgimento de algo ainda maior.

Alguns argumentariam que a IA é uma moda passageira, a próxima bolha esperando para estourar. Estamos mais otimistas do que isso, mas vale a pena pensar em como seria o cenário negativo para as semifinais de IA...

Estamos bastante optimistas quanto às perspectivas da IA, embora em alguns locais decididamente mundanos. Mas ainda estamos nos primeiros dias desta transição, com muitas incógnitas. Estamos cientes de que há uma tendência de pensar entre alguns investidores que estamos em uma "bolha de IA", e a forma dura dessa tese sustenta que a IA é apenas uma moda passageira e que, uma vez que a bolha esvazie, o mercado de semifinais voltará a ser o status quo de há dois anos.

Em algum lugar entre os extremos, a IA é tão poderosa que acabará com a raça humana e a IA é um brinquedo inútil e representa um caso negativo muito mais moderado para os semicondutores.

Tanto quanto podemos avaliar neste momento, o consenso parece sustentar que o mercado para semifinais de IA será modestamente aditivo à procura global. As empresas ainda precisarão gastar bilhões em CPUs e computação tradicional, mas agora precisam de recursos de IA que exigem a compra de GPUs e aceleradores.

No centro deste caso está o mercado de semifinais de inferência. À medida que os modelos de IA se infiltram na utilização generalizada, a maior parte da procura de IA recairá nesta área, tornando a IA útil para os utilizadores. Existem algumas variações neste caso. Alguma demanda de CPU desaparecerá na transição para IA, mas não uma grande aposta. E os investidores podem debater quanto da inferência será executada na nuvem versus na borda, e quem pagará por esse investimento. Mas este é essencialmente o caso básico. Bom para a Nvidia, com muito mercado de inferência sobrando para todos os demais em um mercado em crescimento.

O cenário negativo realmente vem de duas formas. A primeira centra-se na dimensão desse mercado de inferência. Como já mencionamos algumas vezes, não está claro quanta demanda haverá pelas semifinais de inferência. O problema mais flagrante está no limite. Por mais que os usuários hoje pareçam fascinados pela IA generativa, dispostos a pagar mais de US$ 20/mês pelo acesso às novidades da OpenAI, o argumento para ter essa IA generativa feita no dispositivo não está claro.

As pessoas pagarão pelo OpenAI, mas será que realmente pagarão outro dólar extra para executá-lo em seus dispositivos, em vez de na nuvem? Como eles serão capazes de perceber a diferença. É certo que existem razões legítimas pelas quais as empresas não quereriam partilhar os seus dados e modelos com terceiros, o que exigiria inferência no dispositivo. Por outro lado, isso parece um problema resolvido por um grupo de advogados e um Contrato de Licença bem redigido, que certamente é muito mais acessível do que construir um monte de racks de servidores GPU (se você conseguir encontrar algum para comprar).

Tudo isso significa que empresas como AMD, Intel e Qualcomm, que criam grandes expectativas em relação à IA no dispositivo, terão dificuldade para cobrar um preço mais alto por seus processadores prontos para IA. Em sua última teleconferência de resultados, o CEO da Qualcomm enquadrou o argumento do Snapdragon pronto para IA como fornecendo um aumento positivo para a mudança de mix, o que é uma maneira educada de dizer aumentos de preços limitados para um pequeno subconjunto de produtos.

O mercado de inferência em nuvem deveria ser muito melhor, mas mesmo aqui há dúvidas quanto ao tamanho do mercado. E se os modelos encolherem o suficiente para funcionarem razoavelmente bem nas CPUs? Isso é tecnicamente possível, a preferência por GPUs e aceleradores é, no fundo, um caso econômico, mas mude algumas variáveis e, para muitos casos de uso, a inferência da CPU é provavelmente boa o suficiente para muitas cargas de trabalho. Isto seria catastrófico, ou pelo menos muito ruim, para as expectativas de todos os fabricantes de processadores.

Provavelmente o cenário mais assustador é aquele em que a IA generativa desaparece como produto de consumo. Útil para programar e criar e-mails de spam atraentes, mas pouco mais. Este é o verdadeiro caso negativo para a Nvidia, não alguns ganhos nominais de participação da AMD, mas a falta de casos de uso atraentes. É por isso que ficamos nervosos ao ver que todos os fabricantes de processadores parecem tão dependentes da próxima atualização do Windows da Microsoft para despertar o interesse do consumidor na categoria.

Em última análise, acreditamos que o mercado de semifinais de IA continuará a crescer, impulsionando uma demanda saudável em todo o setor. Provavelmente não tanto quanto alguns esperam, mas longe de ser o pior caso, o campo “IA é uma moda passageira”.

Serão necessários mais alguns ciclos para encontrar casos de uso interessantes para IA, e não há razão para pensar que a Microsoft seja a única empresa que pode inovar aqui. Tudo isto nos coloca firmemente no meio das expectativas – a procura estrutural irá crescer a longo prazo, mas haverá altos e baixos antes de chegarmos lá, e provavelmente não haverá zombies pós-apocalípticos com que nos preocupar.

Comentários